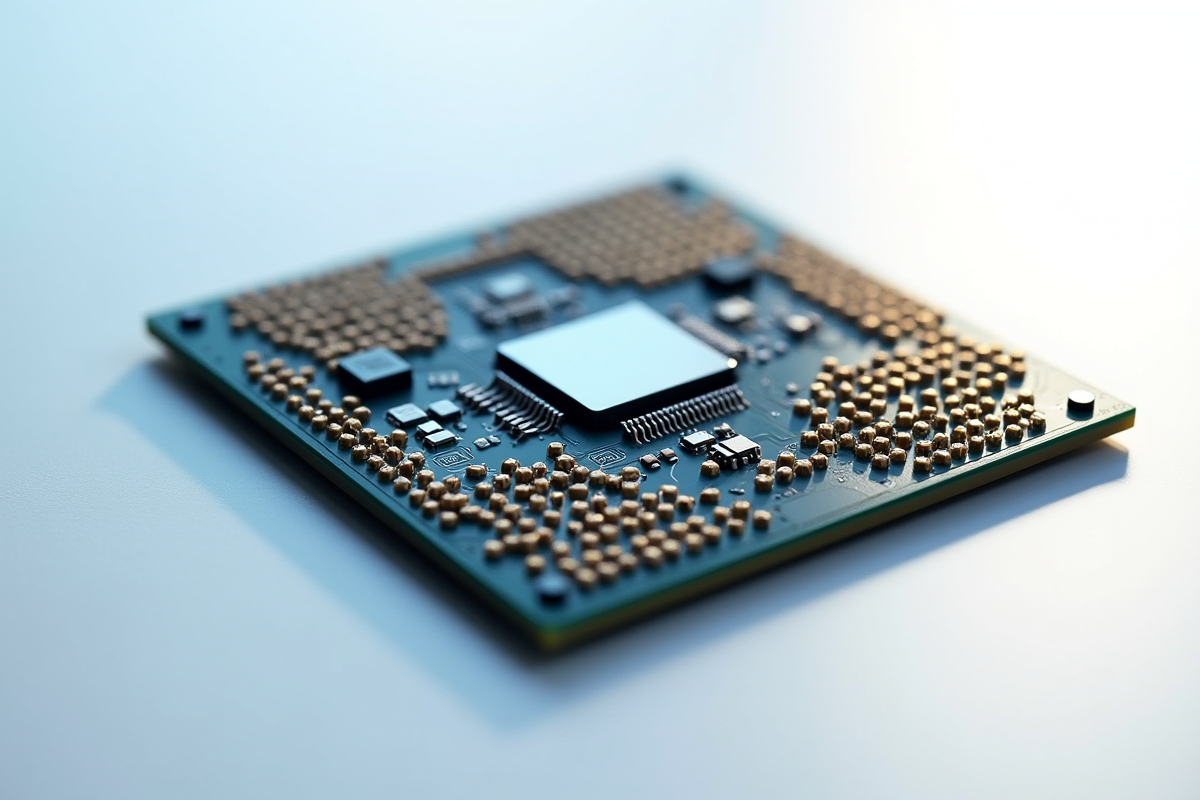

Un chiffre, une tendance et une obsession : le nombre de transistors dans nos processeurs ne cesse de grimper, et avec lui, la promesse de machines toujours plus rapides, plus compactes et plus économes. Les géants du secteur, à l’image d’Intel ou d’AMD, rivalisent d’ingéniosité pour intégrer davantage de transistors sur chaque puce. Derrière cette course, une réalité simple : plus on entasse ces minuscules interrupteurs, plus la capacité de calcul explose, et l’efficacité grimpe d’un cran.

Cette multiplication des transistors n’a rien d’anodin. Elle permet de réduire la taille des circuits, ce qui facilite la miniaturisation des objets électroniques. Résultat : nos smartphones, nos ordinateurs portables, mais aussi les superordinateurs qui scrutent les galaxies, profitent tous de cette avancée. Plus de puissance, moins de place, des appareils qui répondent à la demande croissante d’agilité et de sobriété énergétique.

Comprendre le rôle des transistors dans les processeurs

Le processeur, c’est le cerveau de nos machines. À l’intérieur, ce sont les transistors qui font toute la différence. Ces composants microscopiques s’allument ou s’éteignent à une allure folle, orchestrant les calculs, modifiant et transportant les données. Plus on en case sur une puce, plus le processeur explose ses performances tout en consommant l’énergie de façon plus fine.

Pourquoi plus de transistors améliore la performance

Le bond du nombre de transistors a permis ces dernières décennies d’accélérer massivement le calcul. Voici ce que cette progression a rendu possible :

- Augmentation de la puissance de traitement, car plusieurs instructions s’exécutent en simultané.

- Mémoire cache plus vaste et mieux gérée, d’où un accès accéléré aux données.

- Consommation énergétique plus faible grâce à une gravure fine et à l’optimisation de chaque transistor.

Le secteur informatique s’est appuyé sur la fameuse loi de Moore : ce principe veut que le nombre de transistors double à intervalle régulier. Une cadence suivie pendant des décennies, et à l’origine de progrès vertigineux, génération après génération.

Les défis de l’intégration de plus de transistors

Mais la surenchère ne va pas sans complications. Quand il faut empiler ces minuscules interrupteurs dans des espaces encore plus riquiquis, c’est tout l’équilibre entre performance, gestion thermique et fiabilité qu’il devient nécessaire de réinventer. Les ingénieurs innovent sans cesse sur les matériaux, les architectures, la dissipation thermique. Difficile, mais terriblement stimulant. Pour qui s’intéresse au futur de la microélectronique, chaque étape dans l’intégration de nouveaux transistors trace la voie des prochaines ruptures technologiques.

Évolution de la densité des transistors et ses impacts

Retour sur quelques chiffres qui disent tout du chemin parcouru depuis la promesse de Gordon Moore, dès 1965, de voir le nombre de transistors doubler à un rythme effréné. Le résultat ? Une vraie mue informatique :

| Année | Processeur | Nombre de transistors |

|---|---|---|

| 1971 | Intel 4004 | 2 300 |

| 1982 | Intel 80286 | 134 000 |

| 1993 | Pentium | 3,1 millions |

| 2006 | Intel Core 2 | 291 millions |

| 2021 | Apple M1 | 16 milliards |

Ce bond de densité s’accompagne à chaque étape d’un gain de puissance et d’une baisse des besoins énergétiques. Un point clé se cache derrière cette évolution : la finesse de gravure, exprimée en nanomètres, véritable moteur des puces modernes.

Impacts sur l’industrie technologique

Sur le marché, ces bonds en avant redéfinissent les possibles. Voici quelques exemples de ces effets, concrets et massifs :

- Les performances des processeurs s’envolent, et les applications gagnent en complexité et rapidité.

- La consommation d’énergie chute, d’où des appareils plus visiblement autonomes et des serveurs qui multiplient les tâches sans surchauffer.

- La production devient plus abordable, ouvrant l’accès à la puissance de calcul à une foule de nouveaux acteurs.

Les avantages de l’augmentation du nombre de transistors

L’ajout massif de transistors ne se résume pas à une prouesse technique : pour l’utilisateur, c’est la porte ouverte à des jeux vidéo qui ne sacrifient rien au réalisme, à des IA souples, à des traitements photo ou vidéo instantanés. Prenons quelques repères : le Pentium a inauguré la gestion de deux ports à la volée, le Pentium Pro a aligné trois ports pour décupler le flux. Core 2 a poussé la logique plus loin avec six ports et performances records, tandis que Xeon MP et Itanium 2 ont gonflé la mémoire cache à respectivement 16 Mo puis 24 Mo. Chez Sun Microsystems, le T1 Niagara fait même tourner huit cœurs à plein régime, de quoi faire tourner les applications lourdes sans ralentir.

Ce progrès, côté utilisateur, se mesure par deux éléments : une gestion multi-tâche réellement efficace, et des temps de latence qui fondent pour se mesurer en millisecondes, voire moins.

Avantages concrets pour les utilisateurs

Dans la vie courante, la montée en densité se concrétise par des bénéfices simples et directs :

- Applications qui démarrent vite, même quand la charge est lourde.

- Autonomie accrue pour les smartphones et tablettes, sans sacrifier la rapidité.

- Accès à de la performance haut de gamme, sans exploser le budget.

Sous la surface, c’est un vrai bouleversement à la fois pour le grand public et les entreprises : cette multiplication donne le change à la demande exponentielle en ressources informatiques, tout en gardant un cap sur l’optimisation énergétique.

Défis et perspectives pour l’avenir des processeurs

La densité continue de grimper, mais chaque cap franchi expose aussi des failles. Sverre Jarp, du CERN openlab, met l’accent sur un enjeu vital : la dissipation de la chaleur. Plus on empile de transistors, plus le dégagement thermique devient un casse-tête. Le Grand collisionneur de hadrons, qui engloutit et analyse des données monumentales, dépend d’un pilotage extrêmement précis des températures pour rester performant.

Enjeux énergétiques et efficacité

L’énergie gaspillée est l’autre limite à ne jamais négliger. D’où la recherche obsédante de puces toujours plus sobres, capables de pic de puissance quand il le faut, tout en maîtrisant la consommation dès que possible. Un vrai travail d’équilibriste pour les concepteurs.

Technologies pour l’analyse de données massives

Du côté du CERN, les logiciels comme ROOT ou PROOF exploitent cette abondance de transistors pour découper l’analyse des données en multiples tâches et accélérer tout le process. ROOT classifie et traite, PROOF gère la répartition, tout cela grâce à cette richesse en cœurs et circuits. Ce n’est plus seulement un atout pour la recherche, mais un terrain d’expérimentation pour l’industrie, la finance ou les technologies grand public.

Vers de nouvelles architectures

Ce qui se joue dans les laboratoires aujourd’hui nourrit la feuille de route de demain. De nouveaux schémas d’organisation, des générateurs de nombres aléatoires du type Mersenne Twister, des matériaux de rupture : la course à la densité s’appuie sur de multiples leviers pour garantir puissance, maîtrise énergétique et gestion thermique. Rien n’indique que le cycle s’arrête bientôt, et tant qu’il y aura des défis à relever, chaque transistor supplémentaire renouvellera la promesse d’un saut technologique.